Impacto Medioambiental de ChatGPT

Prácticas sostenibles en el desarrollo de la Inteligencia Artificial (IA): Y un llamamiento a pensar seriamente en el cambio climático sin distraerse: Parte 2.

Utilizar ChatGPT no es Malo para el Medio Ambiente (Parte 2)

Nota: Véase la parte 1 de “Utilizar ChatGPT no es Malo para el Medio Ambiente”.

Por: Andy Masley, director de EA DC.

Las escalas increíblemente pequeñas implicadas en el uso individual de LLMs

«Una pregunta ChatGPT consume 10 veces más energía que una búsqueda en Google»

Es cierto que una pregunta ChatGPT consume 10 veces más energía que una búsqueda en Google. ¿De cuánta energía se trata? Una buena primera pregunta es cuándo fue la última vez que oíste a un científico del clima mencionar la búsqueda en Google como una fuente importante de emisiones. Si alguien te dijera que ha hecho 1000 búsquedas en Google en un día, ¿tu primer pensamiento sería que el impacto climático debe ser terrible? Probablemente no.

Una búsqueda media en Google consume 0,3 vatios-hora (Wh) de energía. La pregunta media de ChatGPT utiliza 3 Wh, por lo que si eliges utilizar ChatGPT en lugar de Google, estás utilizando 2,7 Wh adicionales de energía.

¿Hasta qué punto debería preocuparte gastar 2,7 Wh? 2,7 Wh son suficientes para

Conducir un turismo a una velocidad constante durante 5 metros

En Washington DC, donde vivo, el coste doméstico de 2,7 Wh es de 0,000432 $.

Informar simplemente de una cantidad extremadamente pequeña de energía como múltiplo de otra puede llevar a malinterpretar la gravedad de un problema. Un reloj digital utiliza literalmente un millón de veces más energía que un reloj analógico. Podría escribir un largo artículo sobre cómo sustituir tu reloj por un reloj digital consume un millón de veces más energía que una forma de dar la hora, y que no podemos permitirnos un aumento tan drástico porque ya estamos en una emergencia climática, pero esto sería básicamente una mentira y te haría perder el tiempo preocupándote por algo que en realidad no tiene ninguna importancia para el clima. Considero que las comparaciones entre ChatGPT y las búsquedas en Google son básicamente equivalentes a esto.

Sentarse a ver 1 hora de Netflix tiene el mismo impacto sobre el clima que hacer 300 preguntas a ChatGPT. Sospecho que si anunciara en una fiesta que he hecho 300 preguntas a ChatGPT en 1 hora me acusarían de odiar la Tierra, pero si anunciara que he visto una hora de Netflix o que he recorrido 0,8 millas en mi sedán la reacción sería un poco distinta. Sería extraño que tuviéramos una gran conversación nacional sobre limitar el visionado de YouTube o no comprar nunca libros o evitar subir más de 30 fotos a la vez a las redes sociales por el bien del clima. Si esto ocurriera, los científicos del clima dirían con razón que el público se está atascando en minucias y no se está centrando en las grandes formas reales en que tenemos que actuar sobre el clima. Preocuparse por si se deben utilizar los LLM es una distracción tan grande respecto a los problemas reales del cambio climático como preocuparse por si debes detener el vídeo de YouTube que estás viendo 12 segundos antes por el bien de la Tierra.

Pongamos un caso extremo e imaginemos que la razón por la que no quieres utilizar LLMs es que si todo el mundo utilizara LLMs en lugar de Google para cada búsqueda, esto consumiría demasiada energía. Hay 8.500.000.000 de búsquedas en Google al día. Imaginemos que sustituimos cada búsqueda en Google por una búsqueda en ChatGPT. Eso nos lleva de un consumo energético diario de 2.550.000.000 vatios-hora (Wh) a 25.500.000.000 Wh, es decir, 22.950.000.000 Wh adicionales, o 23 gigavatios-hora (GWh). La demanda global diaria de energía de Internet es de 2.200 GWh, por lo que esto aumentaría la demanda global diaria de energía de Internet en un 1%. Por tanto, un cambio global de Google a ChatGPT sería aproximadamente lo mismo que aumentar en un 1% la población mundial que utiliza Internet. Si supieras que el año que viene un 1% más de personas tendrán acceso a Internet en todo el mundo, ¿hasta qué punto te preocuparía eso por el clima? El año pasado la tasa de crecimiento real de usuarios de Internet fue del 3,4%.

En mi experiencia, utilizar ChatGPT es mucho más útil que una búsqueda en Google, hasta el punto de que prefiero utilizarlo a buscar en Google diez veces de todos modos. A menudo puedo encontrar cosas que busco mucho más rápido con una sola búsqueda en ChatGPT que con varias búsquedas en Google. He aquí una búsqueda que hice pidiéndole que resumiera lo que sabemos sobre las fuentes de energía actuales y futuras utilizadas para los centros de datos estadounidenses. También me ahorra mucho tiempo valioso en comparación con buscar diez veces en Google.

Cuánta gente utiliza realmente los LLM

Muchas quejas sobre el uso total de los LLM no tienen sentido si tenemos en cuenta el número de personas que los utilizan. Al considerar el uso de los LLM, no podemos fijarnos sólo en sus emisiones totales. Tenemos que considerar cuántas personas utilizan el producto. Alguien podría señalar correctamente que Google como empresa produce muchas más emisiones que un Hummer, pero esto es una tontería porque Google tiene miles de millones de usuarios y el Hummer tiene uno, y Google es muy eficiente con la energía que consume cada usuario.

He aquí algunos ejemplos para ilustrar el punto:

«ChatGPT consume la misma energía que 20.000 hogares estadounidenses».

En el momento de escribir estas líneas, ChatGPT tiene 300.000.000 de usuarios diarios y 1.000.000.000 de mensajes diarios contestados. Imaginemos que puedes chasquear los dedos y crear un hogar estadounidense más, con toda su demanda de energía y su impacto medioambiental. Este hogar estadounidense es especial. Las personas que viven en él tienen una afición: dedicar todo su tiempo a escribir respuestas muy detalladas a los correos electrónicos. Disfrutan haciéndolo y no paran nunca, y se les da tan bien que 15.000 personas les envían correos electrónicos todos los días, cada persona enviando una media de 3,3 correos, lo que hace un total de 50.000 correos al día, o 1 correo cada 2 segundos las 24 horas del día. Parece que la gente encuentra útiles sus respuestas, porque el índice de uso sigue aumentando con el tiempo. ¿Elegirías chasquear los dedos y crear este hogar, aunque tenga los impactos climáticos de un hogar estadounidense normal adicional? Parece una compensación claramente buena. ¿Y si tuvieras la opción de hacerlo una segunda vez, de modo que ahora 50.000 mensajes más pudieran ser contestados por un segundo hogar cada día? De nuevo, esto parece merecer las emisiones. Si sigues chasqueando los dedos hasta satisfacer la demanda de respuestas a sus mensajes, habrías creado 20.000 nuevos hogares estadounidenses y tendrías 1.000 millones de mensajes contestados al día. 20.000 hogares estadounidenses es aproximadamente el tamaño de la ciudad de Barnstable, en Massachusetts:

Si apareciera en América una versión adicional de Barnstable Massachusetts, ¿cuánto te preocuparía eso por el clima? Esto supondría un aumento de la población estadounidense del 0,015%. ¿Y si descubrieras que todos los que viven en la nueva ciudad pasan cada momento que están despiertos enviando al mundo párrafos de texto específico extremadamente útil sobre todos y cada uno de los conocimientos humanos y siguen recibiendo peticiones de más? De todos los lugares e instituciones de Estados Unidos para reducir las emisiones, ¿deberíamos empezar por impedir que esa ciudad creciera?

«Entrenar un modelo de IA emite tanto como 200 vuelos de avión de Nueva York a San Francisco»

Esta cifra sólo se aplica realmente a nuestros modelos de IA más grandes, como GPT-4. El uso de energía de GPT-4 en el entrenamiento fue equivalente a unos 200 vuelos de avión de Nueva York a San Fransisco. ¿Mereció la pena?

Para entender este debate, es realmente útil comprender lo que significa entrenar realmente un modelo de IA. Escribir eso llevaría demasiado tiempo y no es el objetivo de este post, así que pedí a ChatGPT que describiera el proceso de entrenamiento en detalle. He aquí su explicación. Lo que es importante entender sobre el entrenamiento de un modelo como GPT-4 es

Es un coste único. Una vez que tienes el modelo entrenado, puedes retocarlo, pero ya está listo para usarse. No tienes que entrenarlo continuamente después ni por asomo con el mismo coste energético.

Es increíblemente complejo desde el punto de vista tecnológico. Entrenar el GPT-4 requirió 2 × 10²⁵ operaciones en coma flotante (cálculos sencillos como multiplicar, restar, multiplicar y dividir). Esto es 70 millones de veces más cálculos que granos de arena hay en la Tierra. OpenAI tuvo que conectar 25.000 GPUs de última generación, especialmente diseñadas para IA, para realizar estos cálculos durante un periodo de 100 días. Es de esperar que este proceso consuma mucha energía.

Nos dio un modelo que puede dar respuestas extremadamente largas, detalladas y coherentes a preguntas muy concretas sobre básicamente todo el conocimiento humano. Esto no es nada.

Rara vez es tan grande y requiere tanta energía. Sólo hay unos pocos modelos de IA tan grandes como el GPT-4. Muchas de las aplicaciones de IA que ves utilizan los resultados del entrenamiento de GPT-4 en lugar de entrenar sus propios modelos.

Es útil pensar si deshacerse de «200 vuelos de Nueva York a San Francisco» movería realmente la aguja del clima. Hay unos 630 vuelos entre Nueva York y San Francisco cada semana. Si OpenAI no entrenara la GPT-4, eso equivaldría aproximadamente a que no hubiera vuelos entre Nueva York y San Francisco durante unos 2 días. No son 2 días a la semana. Son 2 días en total. Incluso si hubiera que volver a entrenar el ChatGPT cada año (y recuerda que no es así), eso es menos del 1% de las emisiones de los vuelos entre estas dos ciudades estadounidenses concretas. ¿Cuánto de nuestro esfuerzo colectivo vale la pena para detener esto?

200 aviones pueden transportar unas 35.000 personas. Unas 20 veces esa cantidad de personas vuelan de todo el país a Coachella cada año. No hay 20 modelos de IA del mismo tamaño que el GPT-4, así que por el mismo coste de carbono podríamos detener todo progreso en IA avanzada durante una década o elegir no celebrar Coachella durante 1 año para que la gente no vuele a él. Esto no parece merecer la pena.

Para poner un número más concreto a la energía que costó entrenar a GPT-4, son unos 60 GWh. El GPT-4 fue entrenado para responder preguntas, así que para considerar el coste energético tenemos que tener en cuenta cuántas búsquedas hemos obtenido de ese uso energético del entrenamiento. Considero que el coste de formación es equivalente a comparar el coste de una camisa con la frecuencia con que te la vas a poner. Si una camisa cuesta 40 $ y está bien hecha para que sobreviva a 60 lavados, y otra camisa cuesta 20 $ pero está mal hecha para que sólo sobreviva a 10 lavados, entonces, aunque la primera camisa sea inicialmente más cara, en realidad cuesta 0,67 $ por uso, mientras que la segunda camisa cuesta 2 $ por uso, por lo que, de alguna manera significativa, la primera camisa es en realidad más barata si tienes en cuenta cómo la utilizarás realmente, en lugar de fijarte sólo en la inversión inicial. Del mismo modo, el entrenamiento de GPT-4 puede parecer caro en términos de energía si no tienes en cuenta cuántos usuarios y búsquedas gestionará.

Una estimación muy aproximada basada en datos disponibles públicamente dice que hasta ahora ha habido unos 200.000 millones de búsquedas en ChatGPT. Esto significa que hasta ahora, si incluimos el coste de formación en el coste energético total de las búsquedas en ChatGPT, añadimos 3 Wh/búsqueda a 60 GWh/200.000.000.000 de búsquedas = 3,3 Wh/búsqueda. El coste de formación distribuido en cada búsqueda añade 0,3 vatios-hora de energía, por lo que aumenta el coste energético total de una búsqueda ChatGPT en 1 búsqueda Google de energía. Esto no parece significativo. Considera ahora que ChatGPT es sólo una de las cosas para las que se está utilizando la GPT-4, otras cosas incluyen DuoLingo, Khan Academy, Be My Eyes, y GitHub Copilot X. Una vez que tienes en cuenta cuánto uso está teniendo, el coste energético de entrenar la GPT-4 parece increíblemente barato, de la misma manera que la camisa más cara inicialmente es globalmente más barata que la segunda.

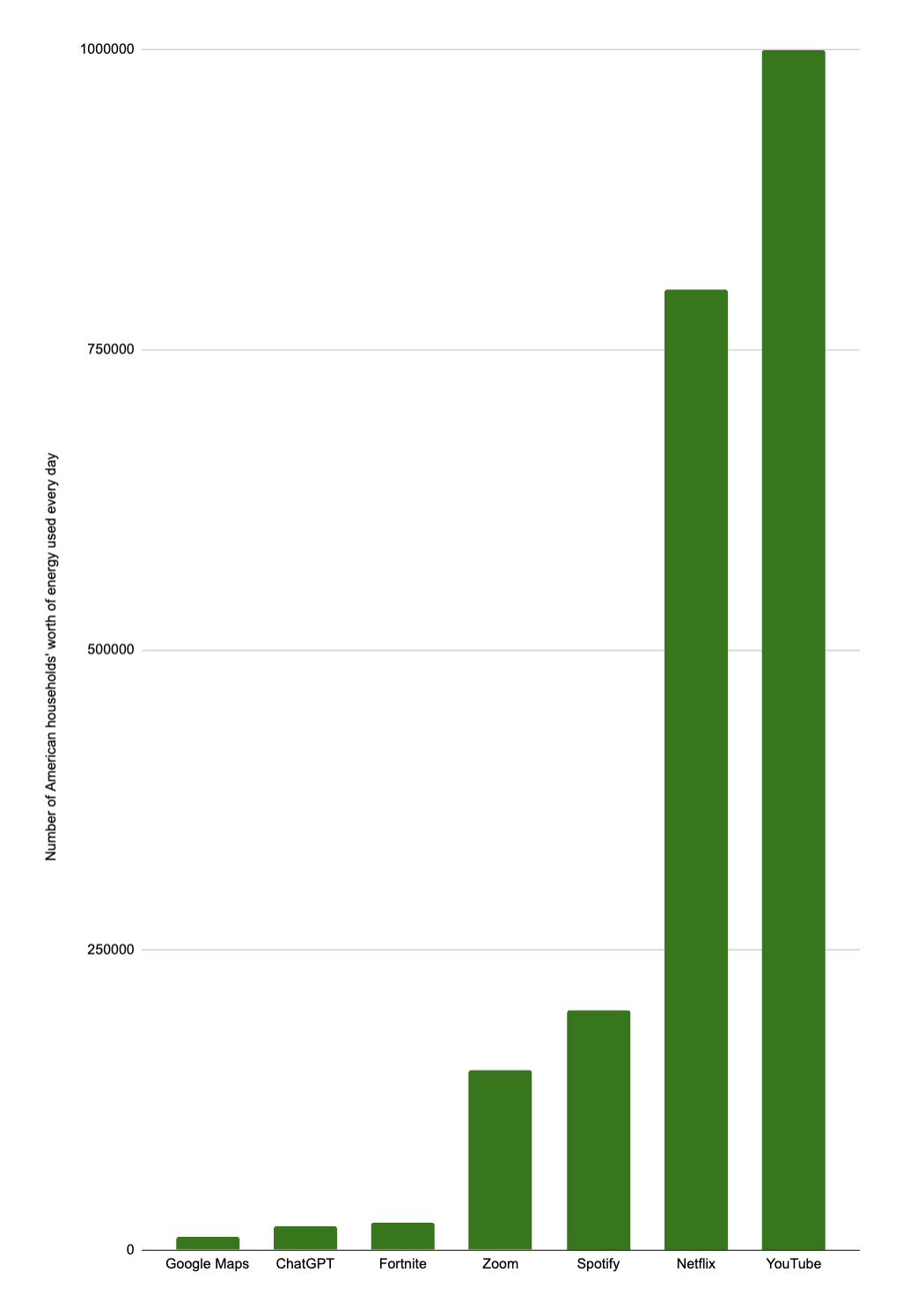

Emisiones de otras actividades en línea

Cuando alguien te lanza una estadística con una gran cifra sobre un producto muy popular, debes tener cuidado con hasta qué punto entiendes realmente las magnitudes implicadas. En realidad, no estamos hechos para pensar en grandes números como éste, así que lo mejor que podemos hacer es compararlos con situaciones similares que nos den más contexto. Internet es ridículamente grande, complejo y utilizado por casi todo el mundo, por lo que deberíamos esperar que utilice una gran parte de nuestra energía total. Cualquier cosa que se utilice ampliamente en Internet vendrá acompañada de cifras llamativas sobre su consumo de energía. Si nos limitamos a mirar esas cifras en el vacío, es fácil hacer que cualquier cosa parezca una emergencia climática.

ChatGPT utiliza tanta energía como 20.000 hogares, pero Netflix declaró haber utilizado 450 GWh de energía el año pasado, lo que equivale a 40.000 hogares. La estimación de Netflix sólo incluye el uso de su centro de datos, que es sólo el 5% del coste energético total del streaming, por lo que el uso real de energía de Netflix está más cerca de los 800.000 hogares. Esto es sólo un sitio de streaming. En total, el streaming de vídeo representó el 1,5% de todo el consumo mundial de electricidad, o 375.000 GWh, o el consumo anual de energía de 33.000.000 de hogares. ChatGPT utiliza la misma energía que Barnstable Massachusetts, mientras que el streaming de vídeo utiliza la misma energía al año que toda Nueva Inglaterra, el estado de Nueva York, Nueva Jersey y Pensilvania juntos. El streaming de vídeo consume 1600 veces más energía que ChatGPT, pero no oímos hablar tanto de ello porque es una parte mucho más normal de la vida cotidiana. 20.000 hogares puede parecer una cifra disparatada si la comparas con tu vida individual, pero es increíblemente pequeña en comparación con el uso de energía en Internet.

A continuación se indica cuántos hogares estadounidenses consumen globalmente la energía que consumen las distintas actividades en línea, según los cálculos que he realizado con la información disponible, más una ciudad estadounidense equivalente que consume la misma energía. He tenido en cuenta tanto la energía utilizada en los centros de datos como la energía utilizada en cada dispositivo individual. Hay grandes barras de error, pero las proporciones aproximadas son correctas.

11.000 hogares - Barre, VT - Google Maps

20.000 hogares - Barnstable MA - ChatGPT

23.000 hogares - Bozeman, MT - Fortnite

150.000 hogares - Cleveland, OH - Zoom

200.000 hogares - Worcester, MA - Spotify

800.000 hogares - Houston, TX - Netflix

1.000.000 de hogares - Chicago, IL - YouTube

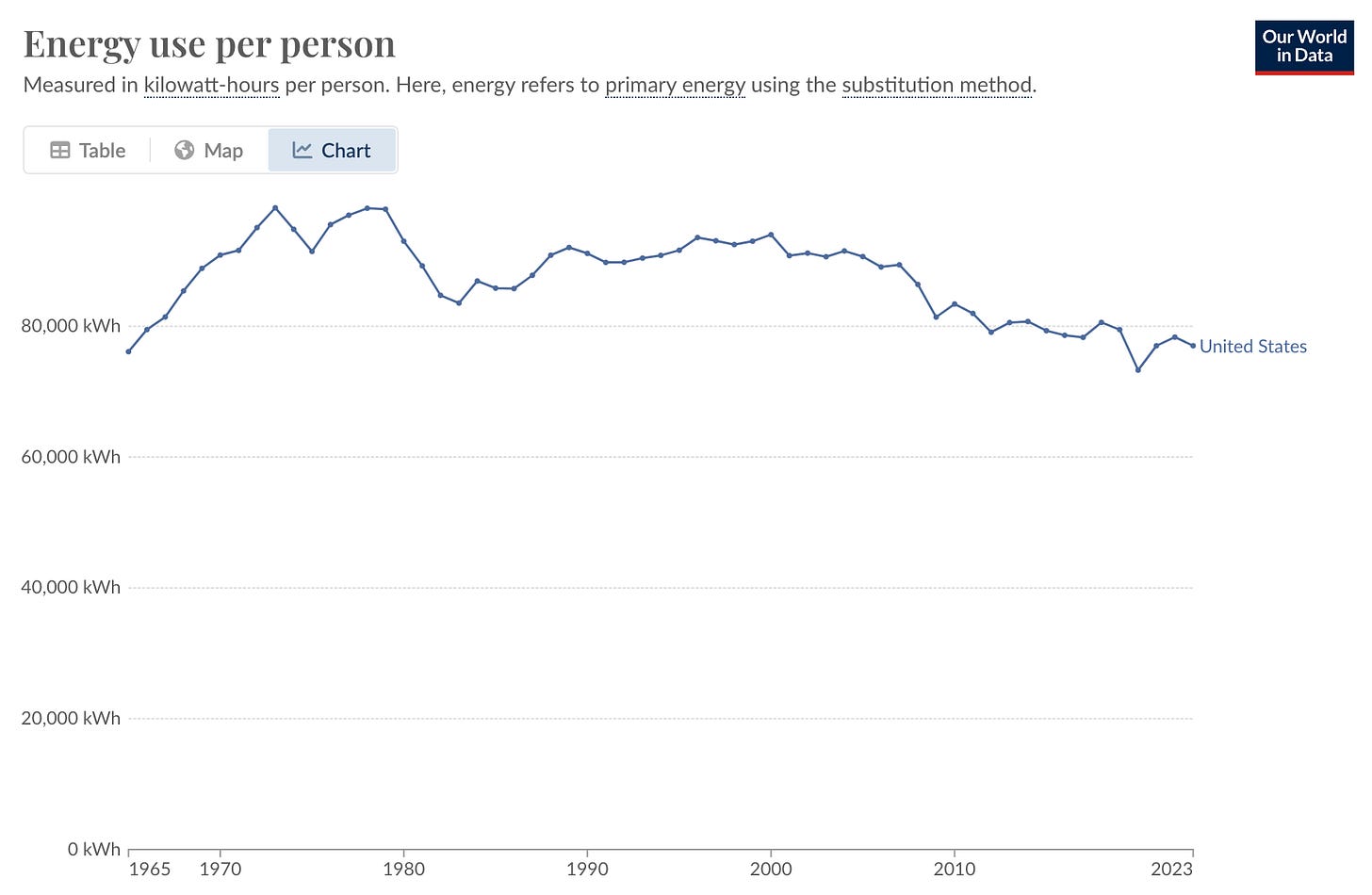

¿Significa esto que debemos dejar de utilizar Spotify o el streaming de vídeo? No. Recuerda la regla de que no debemos limitarnos a reducir los mayores emisores sin tener en cuenta el valor del producto y cuántas personas lo utilizan. Cada transmisión individual de Spotify utiliza una cantidad ínfima de energía. La razón por la que es una parte tan importante de nuestro presupuesto energético es que ¡mucha gente utiliza Spotify! Lo que importa a la hora de considerar qué reducir es la energía utilizada en comparación con la cantidad de valor producida, y otras opciones para obtener el mismo servicio. La energía necesaria para transmitir una canción de Spotify es mucho menor que la necesaria para producir y distribuir físicamente CD, casetes y discos de música. Sustituir los procesos físicos que consumen mucha energía por opciones digitales es parte de la razón por la que el consumo de energía por ciudadano estadounidense ha descendido un 22% desde su máximo en 1979.

Si la gente va a escuchar música, deberíamos preferir que lo haga mediante streaming en lugar de comprar objetos físicos. Decir simplemente que Spotify consume la misma energía que toda la ciudad de Nueva York sin tener en cuenta el número de usuarios, los beneficios que obtienen del servicio o la eficiencia energética que tendrían otras opciones para escuchar música es extremadamente engañoso. Señalar que ChatGPT utiliza la misma energía que 20.000 hogares sin añadir ningún otro detalle es igual de engañoso.

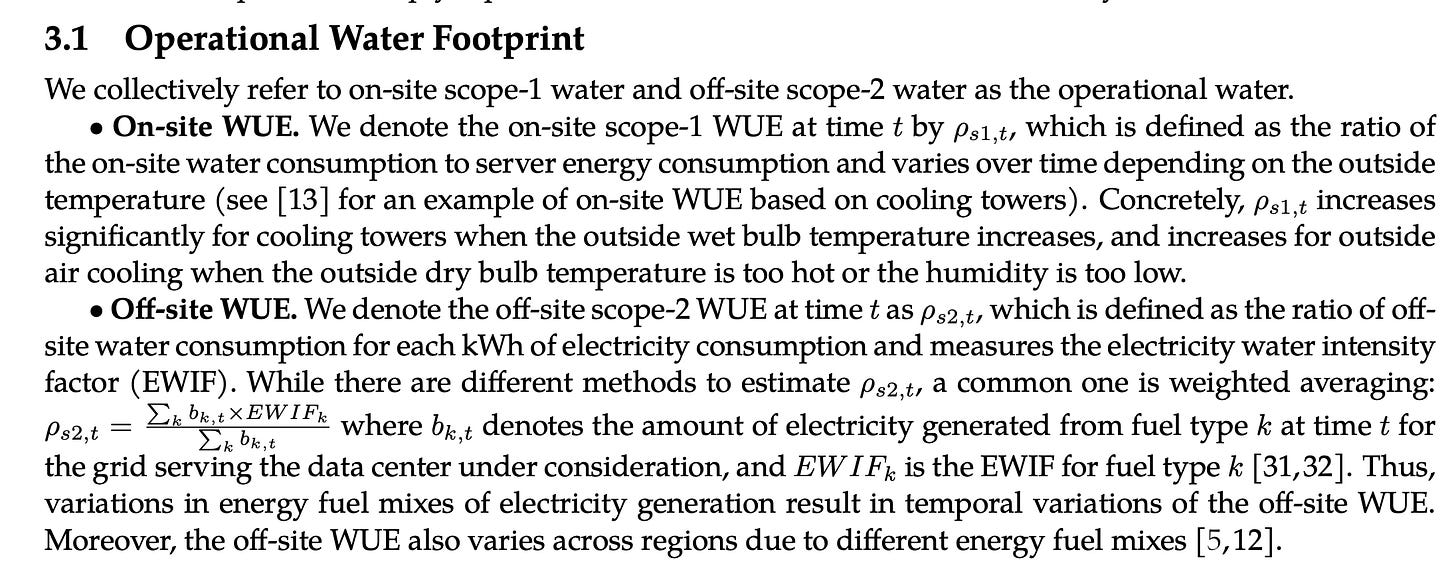

Uso del agua

¿Por qué utilizan agua los LLM? ¿Adónde va después?

He aquí la explicación de ChatGPT de por qué y cómo los centros de datos de IA utilizan agua y adónde va después. En pocas palabras, los centros de datos de IA

Recurren a los suministros locales de agua.

Utilizan agua para refrigerar las GPU que realizan los cálculos. Las GPU de los centros de datos se calientan cuando están activas del mismo modo que la GPU de tu portátil. Al igual que tu portátil utiliza un ventilador interno para enfriarlo, los centros de datos tienen que recurrir a un sistema de refrigeración para sus GPU, y eso implica hacer correr agua por el equipo para evacuar el calor.

Evapora el agua después, o vuélvela a vaciar en los suministros locales.

Algo a tener en cuenta sobre el uso del agua de los centros de datos de IA es que, aunque gran parte del agua se evapora y abandona la fuente de agua específica, los centros de datos generan una contaminación del agua significativamente menor por galón de agua utilizada en comparación con muchos otros sectores, especialmente la agricultura. Obviamente, es importante reflexionar sobre el impacto de los centros de datos de IA en las fuentes de agua locales, y su sostenibilidad depende sobre todo de lo frágil que sea la fuente de agua. Unas buenas políticas de gestión del agua deberían ayudar a tener en cuenta qué fuentes de agua están más amenazadas y cómo protegerlas.

Cómo sopesar moralmente los distintos tipos de uso del agua (centros de datos que la evaporan frente a agricultura que la contamina) parece muy difícil. Los ecosistemas afectados son demasiado complejos para intentar poner cifras exactas a lo malo que es uno en comparación con el otro. Diré que, intuitivamente, un centro de datos que extrae agua de una fuente local pero la evapora sin contaminar de nuevo al sistema de agua local más amplio parece malo para fuentes locales muy específicas, pero no realmente malo para nuestro acceso general al agua, por lo que toda la preocupación podría ser realmente exagerada y no importaría en absoluto si construyéramos centros de datos exclusivamente en torno a suministros de agua estables. Estoy abierto a equivocarme y me encantaría recibir más opiniones en los comentarios. Informar simplemente de que «los centros de datos utilizan X cantidad de agua» sin aclarar si el agua se evapora o se devuelve al suministro de agua local contaminada o no contaminada parece tan vago que es una mala estadística sin más contexto.

¿Cuánta agua utilizan los LLM?

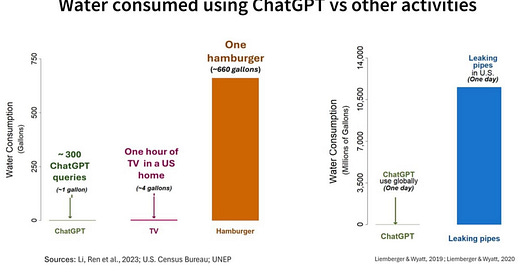

La cifra que se cita a menudo es 20-50 búsquedas en ChatGPT utiliza la misma cantidad de agua que una botella de agua normal (0,5 L).

Sin embargo, esta cifra puede ser engañosa, porque la mayor parte de esa agua no se utiliza en el propio centro de datos.

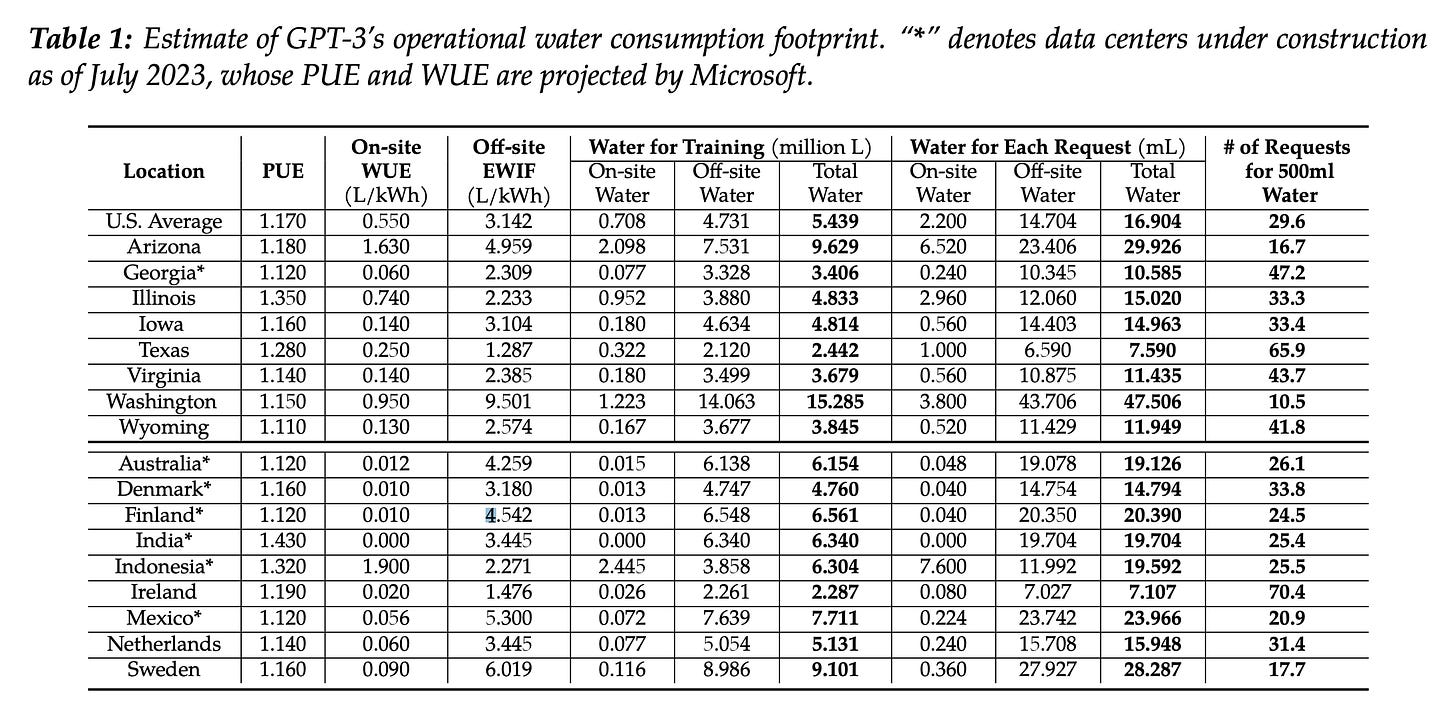

El estudio que nos dio la cifra no sólo midió el agua utilizada por los centros de datos en las búsquedas de ChatGPT, sino que también amortizó el agua consumida por el entrenamiento y el agua utilizada para generar la electricidad que utiliza el centro de datos en primer lugar:

Si te fijas en la sección «Agua por cada solicitud», en la parte superior derecha de la tabla, sólo alrededor del 15% del agua utilizada por solicitud se emplea realmente en el propio centro de datos. El otro 85% o bien se utiliza en la red general de energía estadounidense para alimentar el centro de datos, o bien se amortiza de la formación original. Si alguien lee la estadística «50 búsquedas en ChatGPT consumen 500 mL de agua» podría sacar la conclusión incorrecta de que por el centro de datos tiene que circular una botella de agua por cada 50 búsquedas. En realidad, sólo fluye el 15% de esa botella, por lo que el centro de datos sólo utiliza 500 mL de agua por cada 300 búsquedas.

La cantidad media de agua utilizada para generar 1 kWh de energía en Estados Unidos oscila entre 1 y 9 L . Esto significa que el hogar medio estadounidense (queutiliza 900 kWh de energía al mes) está utilizando entre 900 y 8100 L de agua para generar su electricidad cada mes, agua suficiente para 90.000 - 810.000 búsquedas en ChatGPT. Me preocupa que incluir el agua utilizada en la generación de energía para las búsquedas de ChatGPT pueda inducir a error, porque la gente podría no saber que su uso cotidiano de la energía también utiliza enormes cantidades de agua, y la mayor parte del coste del agua de ChatGPT está midiendo ese mismo tipo de uso del agua, no algún uso especial del agua que se da en los centros de datos. Utilizando los mismos métodos que este estudio, podría decir correctamente que tu reloj digital está utilizando entre 9 y 81 litros de agua al año (tanto como 50.000 búsquedas de ChatGPT si sólo incluimos el agua utilizada en los centros de datos), pero esto sería engañoso si tuvieras una razón para pensar que el propio reloj está utilizando agua internamente. Si suponemos que uno de cada dos estadounidenses utiliza un reloj digital, entonces los relojes digitales estadounidenses están utilizando como mínimo 1.100 piscinas olímpicas de agua cada año. Es una estadística chocante si no la contextualizamos con la cantidad de agua que se utiliza en nuestro sistema energético en general. El sector energético estadounidense en su conjunto utiliza 200 billones de litros de agua al año, suficiente para 80 millones de piscinas olímpicas. ChatGPT utiliza 1.500 piscinas olímpicas de agua (con el agua utilizada para la energía incluida), o el 0,002% del total del agua utilizada para la energía en Estados Unidos.

Si tienes curiosidad por saber por qué se necesita tanta agua para generar electricidad, es porque la mayoría de nuestras fuentes de electricidad se basan en calentar agua para hacer girar imanes alrededor de cables.

Otro problema interesante de esto (que el estudio original señala al final) es que construir centros de datos en desiertos con agua limitada no es necesariamente malo para el suministro total de agua, porque es mucho más fácil utilizar energía solar en los desiertos. La energía solar no necesita agua para generar energía, por lo que construir un centro de datos en un desierto donde pueda acceder a la energía solar reduciría drásticamente su consumo total de agua. Construir centros de datos en zonas con escasez de agua podría ser positivo para el consumo total de agua.

La cantidad de agua utilizada por los LLM puede parecer mucha. Siempre resulta chocante darse cuenta de que nuestras actividades en Internet tienen un impacto físico significativo en el mundo real. El problema de cómo se habla del uso del agua en la IA es que las conversaciones no suelen comparar el uso del agua de la IA con otras formas en que se utiliza el agua, especialmente si utilizamos los métodos para medirla que utilizó el estudio original.

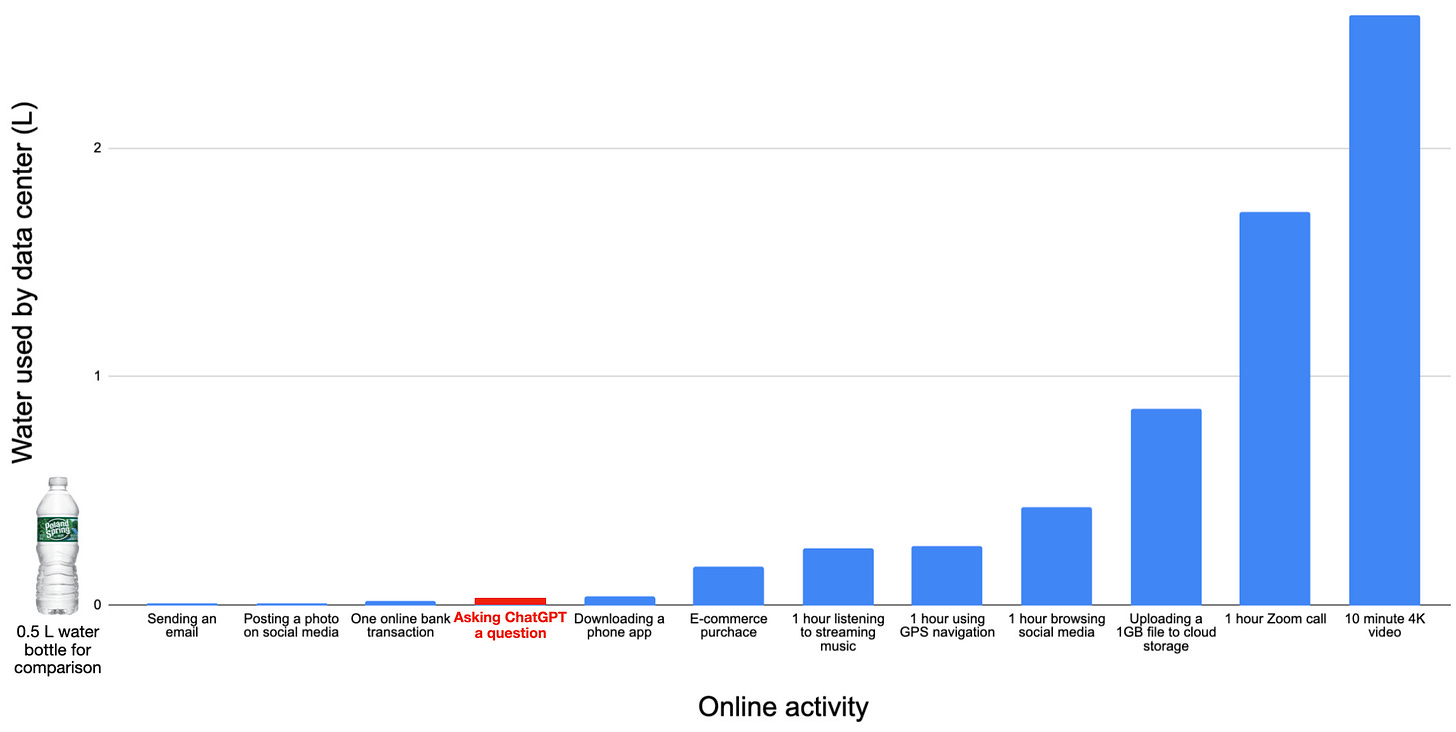

Toda la actividad en línea depende de los centros de datos, y los centros de datos utilizan agua para refrigerarse, así que todo lo que se hace en línea utiliza agua. Además, si utilizamos el mismo método que en el estudio original, el consumo de agua de la mayor parte de la actividad en línea se triplica, porque la mayor parte del agua se emplea en la generación de energía. La conversación sobre los LLM a menudo presenta el agua que utilizan como ridícula, sin dar ningún contexto sobre cuánta agua utiliza el resto de la actividad online. En realidad, es bastante fácil calcular una estimación aproximada de cuánta agua utilizan las distintas actividades en línea, porque los centros de datos suelen utilizar unos 1,8 litros de agua por kWh de energía consumida. Esta cifra incluye tanto el agua utilizada por el propio centro de datos como el agua empleada en generar la electricidad utilizada (igual que el estudio original sobre el uso del agua en LLM). He aquí el agua utilizada en un montón de cosas diferentes que haces en Internet, en mililitros:

10 ml - Enviar un correo electrónico

10 ml - Publicar una foto en las redes sociales

20 ml - Una transacción bancaria online

30 ml - Hacer una pregunta a ChatGPT

40 ml - Descargar una aplicación de teléfono

170 ml - Compra en comercio electrónico (navegación y pago)

250 ml - 1 hora escuchando música en streaming

260 ml - 1 hora utilizando la navegación GPS

430 mL - 1 hora navegando por las redes sociales

860 ml - Subir un archivo de 1 GB a la nube

1720 ml - 1 hora de llamada Zoom

2580 ml - 10 minutos de vídeo 4K

Tras los recientes incendios forestales de California, vi varias publicaciones en redes sociales con más de 1 millón de visitas cada una que decían algo así como «La gente SIGUE usando ChatGPT mientras California SE QUEMA». Deberían haberse centrado más en la gente que ve Lugares Fantásticos en 4k 60FPS HDR Dolby Vision (Vídeo 4K).

¿Debería el movimiento climático empezar a exigir que todo el mundo deje de escuchar Spotify? ¿Sería un buen uso de nuestro tiempo?

¿Y el coste del agua para entrenar a GPT-4? Hasta ahora sólo he incluido el coste de las consultas individuales. Una estimación aproximada basada en la información disponible dice que GPT-4 consumió unos 250 millones de galones de agua, o unos 1.000 millones de litros. Partiendo del supuesto anterior de que ChatGPT ha recibido hasta ahora unos 200.000 millones de consultas, el coste del agua de entrenamiento añade 0,005 L de agua a los 0,030 L de coste de la búsqueda, por lo que si incluimos el coste de entrenamiento, el consumo de agua por búsqueda aumenta aproximadamente un 16%. Eso sigue sin ser tan intensivo en agua como descargar una aplicación en tu teléfono o 10 minutos de música en streaming. Recuerda que ChatGPT es sólo una de las funciones para las que se utiliza GPT-4, por lo que el coste real de agua del entrenamiento por búsqueda en ChatGPT es aún menor.

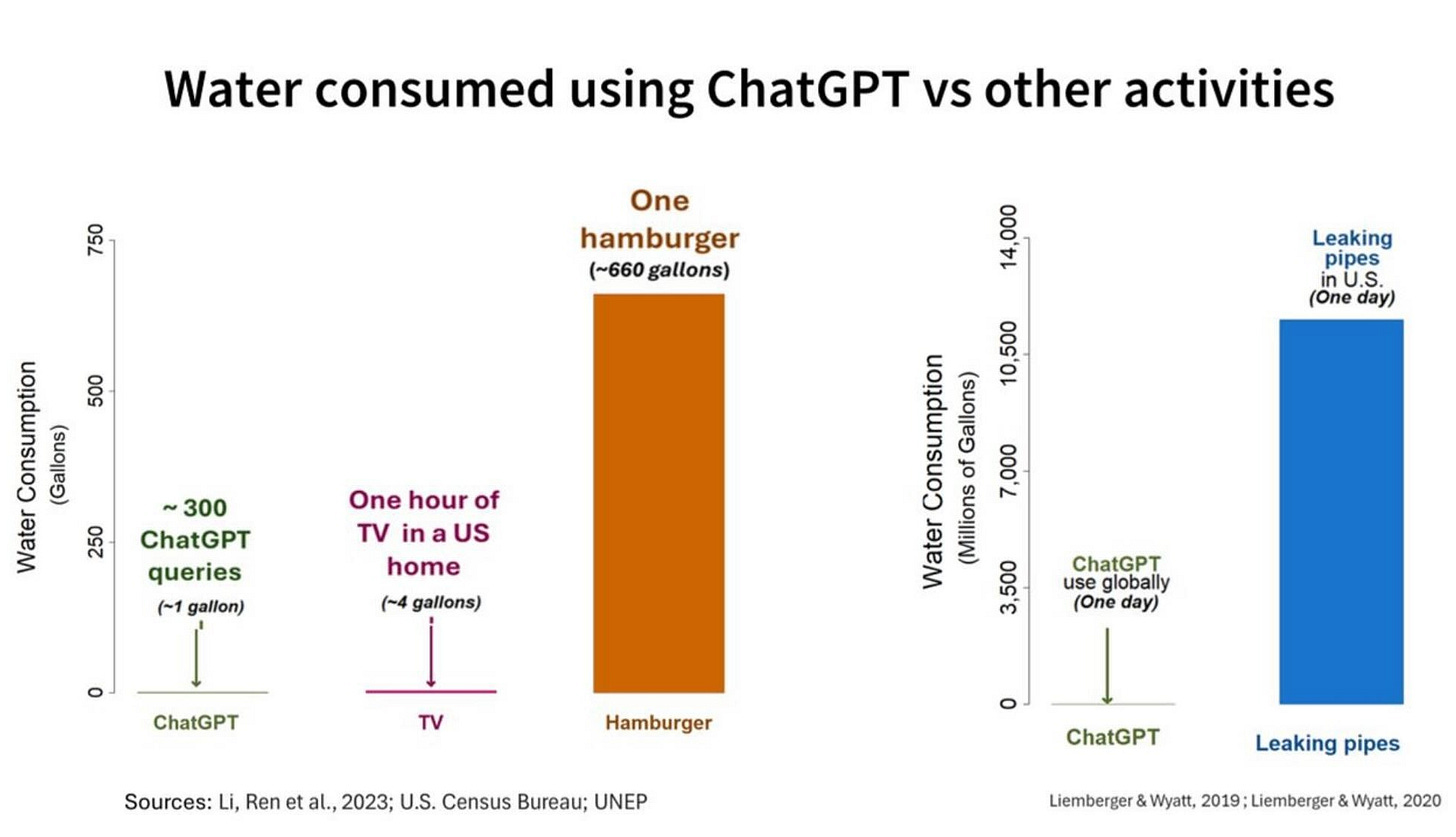

La agricultura animal utiliza órdenes de magnitud más de agua que los centros de datos. Si quisiera reducir mi consumo de agua en 600 galones, podría

Omitir el envío de 200.000 consultas ChatGPT, o 50 consultas cada día durante una década.

Omitir escuchar ~2 horas de música en streaming cada día durante una década.

Saltarme 1 hamburguesa.

En lugar de dejar ChatGPT, considera la posibilidad de hacerte vegano...

Una crítica habitual al gráfico anterior es que el agua que consumen las vacas existe en la hierba, mientras que el agua que se utiliza en los centros de datos se extrae de fuentes locales que a menudo ya están saturadas de agua. Esto no es correcto por tres razones:

Sólo el 5% del ganado vacuno de Estados Unidos se alimenta de hierba.

Alrededor del 20% de las vacas de carne de EEUU están en Texas, Colorado y California. Cada estado ha experimentado importantes tensiones en sus recursos hídricos. Aproximadamente el 20% de los centros de datos de EE.UU. extraen agua de cuencas hidrográficas sometidas a una presión moderada o alta, sobre todo en las regiones occidentales del país, por lo que parece que ambas industrias tienen aproximadamente el 20% de su actividad total concentrada en lugares donde pueden estar perjudicando a las cuencas hidrográficas locales.

Los centros de datos contaminan las reservas locales de agua bastante menos que la ganadería.

Como ya se ha explicado, los centros de datos construidos en zonas con escasez de agua probablemente consumen mucha menos agua porque pueden recurrir a la energía solar.

Si intentas reducir tu consumo de agua, eliminar el uso personal de ChatGPT es como pensar en qué parte de tu vida puedes reducir tus emisiones con mayor eficacia y empezar por deshacerte de tu despertador digital.

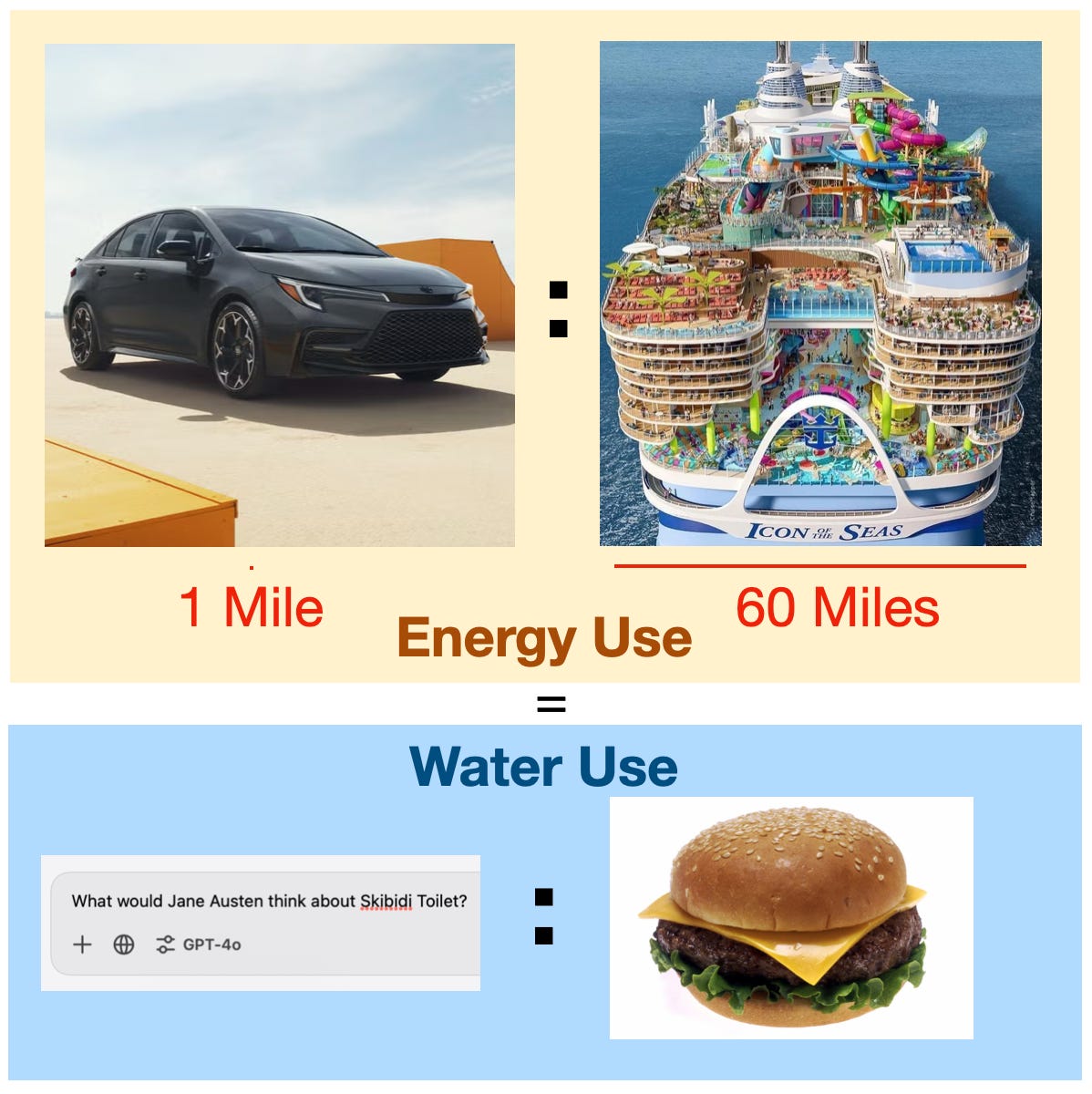

Un cálculo aproximado me dice que la relación entre el consumo de agua de una búsqueda de ChatGPT y el de una hamburguesa es la misma que la relación entre el consumo de energía de un viaje de 1 milla en un sedán y el consumo de energía de conducir el crucero más grande del mundo durante 60 millas.

Si tu amigo estuviera a punto de conducir en solitario su crucero personal más grande de la historia durante 60 millas, pero decidiera caminar 1 milla hasta el muelle en lugar de conducir porque le «preocupa el impacto climático de la conducción», ¿hasta qué punto le tomarías en serio? La situación es la misma con el uso del agua y los LLM. Hay problemas que eclipsan tan completamente el uso individual de agua de los LLM que no tiene sentido que el movimiento climático se centre en absoluto en el uso individual de los LLM.

Las personas que intentan decirte que tu uso personal de ChatGPT es malo para el medio ambiente están fundamentalmente confundidas sobre dónde se utiliza el agua (y la energía). Se trata de un concepto erróneo tan extendido que deberías hacerles saber educada pero firmemente que están equivocados.

Sobre The Weird Turn Pro

La newsletter The Weird Turn Pro existe para compartir las ideas que le han sido útiles o importantes a Andy Masley. En realidad, como él explica:

“no tengo ideas individuales originales que compartir. En su lugar, intentaré combinar fragmentos de conocimientos de distintas fuentes de formas nuevas para mostrar un patrón general o una vibración que considere importante o interesante.”

Un punto que merece la pena señalar aquí es que la crítica medioambiental de los LLM parece haber sido «transferida» de la misma crítica de la tecnología blockchain y los NFT. La crítica medioambiental de las NFT es, hasta donde yo sé, válida: vender 10 NFT hace tanto daño, en términos de emisiones de carbono, como cambiar a un coche híbrido hace bien. Lo que puede haber ocurrido es que dos coaliciones que discutían sobre una tecnología simplemente reciclaron los mismos argumentos cuando apareció una tecnología más nueva, supuestamente de alto consumo energético.

No es una hipótesis mía, pero me parece muy plausible. No veo de qué otra forma podrían haberse aferrado a este argumento los detractores de la IA, ¡cuando hay muchos otros argumentos perfectamente válidos sobre las desventajas de las LLM!

Hacer 300 preguntas al ChatGPT, lo que representa al menos varias semanas o incluso varios meses de uso para un usuario medio, consume en realidad 600 veces menos agua que producir una sola hamburguesa, como muestra esta completa investigación de Andy Masley, ahora en español.